图片来源:Pixabay

1993年,30岁的黄仁勋(Jensen Huang)和合作者共同创立了图形和游戏硬件公司英伟达(NVIDIA)。直到今天,图形和游戏显卡依然是这家公司的主要收入来源。但早在2019年,四大云服务提供商AWS、谷歌、阿里巴巴和Azure已有97.4%的人工智能(AI)加速器(用于提高处理速度的硬件)部署了英伟达的图形处理器(GPU)。Cambrian AI Research 的分析师Karl Freund表示,英伟达占据了AI算法训练市场“近乎100%”的份额。超算500强中有近七成使用其GPU。上个财年,英伟达在数据中心市场的GPU销售额攀升至了67亿美元。英伟达见证了人工智能领域几乎所有的里程碑:吴恩达领衔研发的YouTube寻猫程序、DeepMind的围棋冠军AlphaGo、OpenAI的自回归语言模型GPT-3都在其硬件上运行。英伟达的硬件已经成为了人工智能领域的地基。

尽管取得了这样的成功,质疑英伟达从游戏转向AI是瞎猫碰见死耗子的声音仍然不绝于耳,在英伟达领导深度学习(deep learning)研究的Bryan Catanzaro对此相当恼火:“十年来,英伟达在进军AI市场的路上始终步步为营。”

关于英伟达如何从游戏和图形硬件公司转型为AI芯片“霸主”的故事,业内有这样一则八卦——它和“猫”有关。2010年,现任英伟达首席科学家Bill Dally与他在美国斯坦福大学的前同事、计算机科学家吴恩达(Andrew Ng)共进早餐,彼时后者正在与谷歌合作开展一个项目,想要教会算法在互联网上“找猫”。

吴恩达当时构建的神经网络已经“观看”了1000万段YouTube视频,学会了认出人脸、身体和猫——但要准确做到这一点,整个系统需要数以千计的中央处理器(CPU)提供算力。Dally和他打赌说,同样的事只要几块GPU就能做到。GPU被专门用来处理像3D渲染这样的密集负载——这令它在驱动AI时的表现比CPU更出色。

为了实现这一目标,Dally找到了Catanzaro。他做到了——12块GPU,就在训练吴恩达的识猫模型时展现出了比CPU更快、更有效率的并行处理能力。

但Catanzaro希望人们知道,英伟达在AI领域的发力并不是因为那次偶然的早餐。事实上,在2008年加入英伟达之前,他还在加州大学伯克利分校读研究生的时候就已经在为AI开发GPU了。“英伟达在这个市场上获得的地位并非偶然。”他说。

十年后,人工智能和芯片产业越来越成熟,变革将至。越来越多的企业开始利用AI来理解收集到的海量数据,而各国政府则向深度学习领域注入资金,以保持领先地位,中美之间的竞争尤为激烈。Deloitte分析师Costi Perricos表示,人工智能将成为各国竞争“下一个超级大国”的焦点领域。与此同时,深度学习模型的规模和复杂度也在不断增加,需要更多的算力。

OpenAI的GPT-3 就是一个极端的例子。它是一个可以写出通顺文本段落的深度学习系统,包含1,750亿个参数。GPT-3的计算成本约为460万美元,此后被包含1.6万亿个参数的谷歌语言模型超越。高效能的硬件至关重要——为了处理更多的参数和数据进而提高模型准确率,也为了降低AI造成的环境影响。据丹麦研究人员计算,训练GPT-3所耗能量形成的碳足迹相当于驾车行驶70万公里。

我们需要更多的AI芯片,我们也需要更好的AI芯片。虽然英伟达是早起的鸟儿有虫吃,但后来的挑战者们正竞相追赶。谷歌2015年开始制造自己的芯片;亚马逊2016年收购了Annapurna Labs,去年开始把Alexa智能大脑迁移到自己的Inferentia芯片上;百度旗下的昆仑芯片公司最近获得了20亿美元(130亿人民币)的估值;高通推出了Cloud AI 100芯片;IBM正致力于高能效设计。AMD收购Xilinx,发展AI数据中心业务;英特尔2019年在其Xeon数据中心的CPU中集成了AI加速,还在2016年以4.08亿美元收购了Nervana,2019年以20亿美元收购了Habana Labs。那些仍在待价而沽的初创公司也已推出了自己的硬件,在过去的几年里,Graphcore、SambaNova、Cerebras、Mythic AI等公司陆续测试或者发布了AI芯片。

人工智能方兴未艾。识猫算法距今只有十年,这些初创公司也大多不过数年历史。智能物联网设备掀起了一场机器互联革命,更多的数据将会随之涌现,所有人的目光投向了同一件事:掌握AI芯片的未来。

图片来源:Pixabay

GPU和它的竞争者们

机器学习是一种与众不同的计算负载,需要在数字精度较低的条件下开展大量数学运算。传统的高性能计算 (high-performance computing, HPC) 靠多个系统互联构建超级计算机,以处理像科学仿真和金融建模这样的复杂工作负载,这需要使用至少64位的数字进行高精度运算。AI计算也需要大规模的计算基础设施,但不需要那么精确的数学。它使用的数字是16位,甚至可以是8位——和HPC相比这有点像80年代的像素游戏碰上了次世代图形。AI芯片初创公司Cerebras的首席执行官Andrew Feldman 说:“大部分数学运算很简单,但计算量非常大。”

AI芯片是经过编程框架(例如Google的TensorFlow和Facebook的PyTorch)优化,用以运行机器学习工作负载的处理器。在训练或者运行深度学习模型时,AI芯片无需“事必躬亲”,而是作为加速器快速处理最密集的工作负载。例如,英伟达的盒装AI系统DGX A100使用8块自研的A100“Ampere”GPU作为加速器,但也配备了128核的AMD CPU。

AI 不是个新事物了,但我们以前的算力不足以支撑深度学习模型,研究人员只能等待硬件赶上他们的想法。“GPU 的出现打开了大门。”另一家制造 AI 芯片的初创公司 SambaNova 的联合创始人兼首席执行官 Rodrigo Liang说。

2012年,加拿大多伦多大学(University of Toronto)的研究人员Alex Krizhevsky在一年一度的ImageNet计算机视觉挑战赛中击败了其他竞争对手。这一比赛让研究人员相互竞争,开发可以识别图像或者物体的算法。Krizhevsky首次使用由GPU驱动的深度学习算法击败了人类的手动编码。到了2015年,所有在ImageNet竞赛中名列前茅的成绩都用的是GPU。

深度学习研究就此爆发了。英国初创芯片公司Graphcore联合创始人兼首席技术官Simon Knowles回忆起2015年前往加州寻求融资的经历时,表示一些投资人甚至不懂什么是AI。但几个月后,也就是2016年初,局势彻底变了。“那时,人人都开始热衷人工智能,”Knowles说,“然而,他们对芯片并不感冒。”英伟达的技术可以提供超过20倍的性能提升,它的表现是如此良好,以至于同行们根本拉不到投资。新的芯片架构被认为没有必要,英伟达已经覆盖了整个行业需求。

但是,在2016年5月,谷歌改变了这一切,他们宣布为人工智能应用开发了自己的芯片,Cerebras的Feldman称之为“大胆的战略决定”。这些芯片被称为张量处理器(tensor processing unit, TPU),专门为谷歌自己的机器学习编程框架TensorFlow而设计。Knowles表示,此举向投资者们传递了一个信号:设计新型处理器或许会有市场。“一夜之间,所有风投都在想:那些疯狂的英国人在哪儿?”他说。那之后,Graphcore已经筹集到了7.1亿美元。

英伟达的竞争对手称,尽管GPU强大的处理能力令其在AI任务上的表现比CPU更胜一筹,但GPU的设计用途是图形处理而非机器学习。依靠着精心优化和复杂的软件层,GPU的AI市场主导地位才能维持这么久。“英伟达把GPU的复杂性隐藏得非常好。”Graphcore联合创始人兼首席执行官Nigel Toon说。“他们创建的软件库、各种框架和优化使复杂性得以隐藏。英伟达在这里下了很大功夫。”

不过即使抛开GPU不谈,关于芯片的争鸣还会继续。你可以从头设计一款全新架构的AI芯片,有很多技术路径可供选择:谷歌的 TPU 属于专用集成电路 (ASIC),专为特定工作负载设计;Cerebras制造了“晶圆规模引擎”,这是一款比普通芯片大56倍的巨型芯片;IBM和BrainChip模仿人脑来制造神经仿生芯片;Mythic和Graphcore以不同的设计方式造出了智能处理单元 (IPU)……如此等等,不一而足。

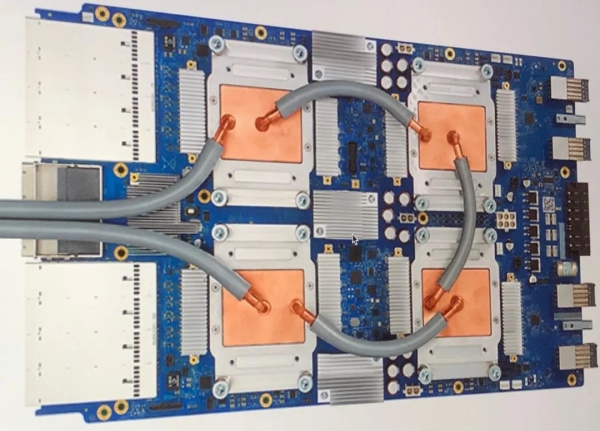

TPU3.0 图片来源:Zinskauf,CC BY-SA 4.0,

但英伟达的Catanzaro认为,这些形形色色的芯片不过是AI加速器的变体——任何能加速AI计算的硬件,都叫AI加速器。“我们谈论的可以是GPU、TPU、IPU或者其他任何东西,但人们对这些字母过于执着。”他说,“我们把产品称作GPU是出于历史原因……但GPU一直用于加速计算,只是人们关心的工作负载性质在不断变化。”

跑分竞争

谁能与英伟达争锋?核心基准测试MLPerf是衡量深度学习芯片的黄金标准,尽管这类基准测试是块“难啃的硬骨头”,但英伟达仍能在MLPerf中独领风骚。Cambrian AI Research的分析师Karl Freund指出,学术机构和包括谷歌在内的业界玩家创建了基准测试工具MLPerf,谷歌和英伟达在榜上一骑绝尘,但对初创公司来说,与其花费大量精力逐个通关,不如把资源集中到别处更划算。

但是英伟达不这么想,他们每年都要超越谷歌的TPU。“谷歌创建了MLPerf来展示他们的TPU有多厉害。”英伟达解决方案架构和工程负责人Marc Hamilton表示,“黄仁勋说,要是我们的GPU总能在谷歌跑MLPerf基准测试的时候比他们的TPU快一点点,那就太好了。”

为了确保能在基准测试的某个版本中名列前茅,英伟达将一台公司内部的超级计算机从36个DGX模块升级到了惊人的96个。这需要将整个系统重新布线。为了尽快完工,他们干脆切断了这套价值约100万美元的设备的电缆,直接把新设备加了上去。这或许能凸显跑分驱动的行为有多么疯狂,但它也启发了英伟达对DGX的重新设计:当前款式的模块可以20个一组互联,无需重新布线。

更低的功耗

在基准测试和超级计算机上,你可以随时添加更多芯片。但在AI 计算的另一方面——边缘推理(inference at the edge),就不是这么一回事了。

英伟达在2020年出价400亿美元收购了英国芯片设计公司ARM。这家公司的芯片架构为全球95%的智能手机提供支持,让这次收购引起了全世界的关注。但反响并不都是积极的。卸任后保留股份的ARM联合创始人Hermann Hauser称这是一场“灾难”,可能会破坏ARM在市场上的中立性。欧盟、英国、中国和美国——世界各地的监管机构正在严密地关注着这笔交易。

ARM设计芯片,将知识产权授权给其他公司供其使用。如果AI芯片制造商需要CPU来搭建系统,他们就可以从ARM那里获取芯片设计方案,然后自定规格来制造芯片。尽管黄仁勋“明确”表示英伟达会尊重ARM的开放模式,但竞争对手担心,英伟达对ARM的控制可能会限制这类合作关系。据报道,英国政府正在研判这桩收购案对国家安全可能产生的影响(ARM被英伟达收购前归日本软银所有);而中国则担心在现有的贸易形势下,如果ARM落入美国公司手中,可能会导致一些中国公司因为限制而无法购买其设计方案。

ARM是边缘推理芯片的主要设计厂家,这类芯片可以把深度学习应用于现实世界。这意味着,这次收购可能会对市场产生巨大影响;在ARM加持下,英伟达可以凭借GPU和ARM在数据中心和边缘计算领域都占据主导地位。

何为边缘推理?英伟达强大的高性能系统通过处理数据来训练和应用模型,但还有另一种AI负载叫做推理,这种任务更轻量,使用经过训练的模型来诠释一些东西——例如无人驾驶汽车解读摄像头拍到的画面;智能手机应用可以识别面部轮廓,在自拍照中为你加上猫耳;或者是医学成像模型在扫描中发现癌症的迹象。训练过程需要大量的算力,要在数据中心完成,但推理可以在两处进行。

一处也是在数据中心:当你向Alexa或者Siri提问时,语音会被上传到亚马逊和苹果的服务器进行转录和回复。另一处则在终端用户设备,例如相机、汽车和智能手机——这被称为边缘计算(edge computing)。边缘计算对处理能力要求不高,但需要快速反应(没人希望无人驾驶汽车会在刹车前陷入沉思)。

英伟达目前在数据中心端执天下牛耳。它的A100芯片可以处理数据、训练模型,而推理任务则被虚拟化到更小的微型服务器上,同一硬件可以同时运行超过50个推理负载。这对像AWS这样提供AI服务的科技巨头很有帮助,因为多个客户可以使用同一硬件而没有数据泄露的风险。在边缘计算领域,英伟达有用于无人驾驶汽车的DRIVE和用于现场推理的EGX,但低功耗芯片并非其传统强项——如果你用过游戏笔记本电脑,你会注意到它需要比谷歌的笔记本电脑Chromebook更频繁地充电。低功耗芯片研发是ARM的优势领域,这也是英伟达斥资400亿美元收购该公司的原因。

有了边缘AI,语音助手不必将语音上传到AWS或者Apple服务器上处理,而是可以基于本地智能做出响应。ARM的IP产品部总裁Rene Haas说:“这让信息可以在源头处就地处理,在很多层面都有助于提高效率。”他指出,本地向云端来回收发数据会加快电池电量的消耗。这一转变,正是英伟达收购ARM计划的核心。

超算布局

过去一年里,当其他人被困在家里,就着香蕉面包狂刷Netflix的时候,英伟达解决方案架构与工程部门主管Marc Hamilton大部分时间都在忙着在英国搭建一台价值4000万英镑的超级计算机Cambridge-1,他克服了疫情带来的物资短缺,大体按时完成了组装工作。英伟达模块化的系统降低了搭建难度。八块A100芯片组成了被称为 DGX的计算系统核心——它和你笔记本电脑里面跑的那块Intel或者AMD芯片在角色上是类似的。DGX成本高达19.9万美元,采用即插即用式设计,包含内存、网络以及其他所有功能。80台DGX以每20台为一组的模块化形式,撑起了Cambridge-1的“SuperPod”系统。

Hamilton表示,Cambridge-1将成为英国规模最大、算力最强的AI超级计算机,可以进入世界前40(排名可能会发生变化)——但在英伟达自己的超算序列中它的规模将只能屈居第五。Cambridge-1使用80个DGX A100盒子搭建,而英伟达的最强超算Selene使用了560个盒子。

英伟达把Cambridge-1建在英国,部分原因是他们收购了ARM,这意味着ARM在英国的员工会加入英伟达。虽然整体来看,Cambridge-1既不是最快的,也不是最大的,但它宣称创下了两个第一。Hamilton称其为世界上第一台云原生(cloud-native)超级计算机,因为它具有类似于AWS的分区功能,可以让不同公司使用同一硬件而没有安全漏洞或者数据泄露的风险。这也让Cambridge-1创造了第二项第一:这将是英伟达唯一向外界合作伙伴开放的超级计算机,可以让大学和医疗保健巨头阿斯利康(AstraZeneca)、牛津纳米孔公司(Oxford Nanopore)和葛兰素史克(GSK)运行他们自己的深度学习模型。

为什么英伟达要建造自己的超级计算机?一个原因是,他们需要“玩具”来吸引最优秀的人才。2016年的时候,英伟达还没有超算,Facebook和谷歌将市面上最优秀的AI研究人员一扫而空。“这不是因为他们给的钱更多,”Hamilton说,“而是因为谷歌和Facebook拥有数以千计的GPU来跑业务,并且他们的AI研究人员可以使用这些GPU。”

现在,英伟达的Selene是世界第五大超级计算机,仅次于日本的“富岳”、中国的“神威·太湖之光”和美国的两台超算(编者注:在2021年6月底发布的第57次世界超算500强排名中,Selene被惠普公司制造的Perlmutter超过,排名世界第六)。Hamilton说,这意味着如果你是一名想要使用速度最快的AI硬件的研究人员,你就要在中国、美国或者英伟达中选一个。中国的目标是在2030年成为AI领域的全球领导者,而美国则希望保持其在技术上的领先地位。AI竞争前沿已经出现了紧张局势,作为一家美国公司,英伟达无法置身事外。

Catanzaro领导的40人实验室开发用于英伟达自己计算系统的AI,但该实验室还是系统架构师的“试验田”,可以一窥深度学习模型在未来的工作方式。“如果你想打造未来芯片,希望它将来还能一展拳脚,你就必须有能力预测未来最重要的工作负载是什么——它们在计算层面是什么样子。”Catanzaro说,“如果预测错误,芯片开发就会步入歧途。” 芯片的设计制造需要数年时间,因此这种远见是必要的。

如果有朝一日开发出来的模型弃GPU而去,或者在GPU上跑得不那么好,会发生什么?英伟达的Dally承认存在这种可能性,但由于大多数研究人员都在研究GPU,他认为可能性不大。“在新模型上线之前,我们通常就已听说过它,并有机会对其进行测试,确保它在我们的GPU上运行良好,”他说。

其他人表示反对——他们认为, GPU可能会限制深度学习模型充分发挥潜力。“每个人在开发模型时都在为当前的硬件技术削足适履。”Cerebras的Feldman说,“我们最高兴、也最兴奋的事情之一,就是一群客户正在编写全新的模型。” 他表示,今年Cerebras将展示所谓“GPU不好使”的实例——这些工作压根无法用GPU完成。

AI芯片的未来

Graphcore的Toon表示,研究人员早就向他表达过为当前硬件所困的局面;他的搭档Knowles将其比作奥威尔的“新语”——简单的语言会阻止人们思考更复杂的问题。“有一些点子,例如概率机器学习,仍然窒碍难行,因为这些想法在像GPU这样的硬件上难以向前发展。”Toon说,“竞争的焦点在于,英伟达能以多快的速度改良GPU,还是会有新事物来实现这些想法?”

麻省理工学院计算机科学和人工智能实验室的研究员Neil Thompson则在AI会议上注意到这样一种趋势:研究人员暗示,计算方面的限制阻碍了他们的模型,限制了他们的选择和数据集,并让一些人不得不在工作中留下错误,因为他们无法负担重跑一遍模型的高昂成本,难以修复问题。“这真的很普遍,如果我们安常守故,对于深度学习的未来而言将会是一个非常大的问题。”他说。

Thompson和同事一起分析了1058篇AI论文,发现机器学习算力需求的增长远远快于硬件改良或者训练效率提升。这样下去,我们迟早需要花费数亿甚至数十亿美元来训练模型——而且还有其他成本。“使用越来越多的GPU训练模型的问题在于,GPU数量每增加一倍,成本就会翻番,环境足迹、碳排放和污染也会翻番。”Thompson说。

他认为,无论是英伟达还是后起之秀,仅仅依靠硬件解决方案,都不足以帮助AI创新走出困境。相反,我们需要构建更高效的模型,同时更好地利用已有的模型。诸如稀疏化之类的想法(忽略数据集中的0以节约计算资源)可以精简数据,只保留关键参数,从而提供帮助。另一个想法是将模型提炼成更轻量的方程,抛开臃肿的通用模型,只运行需要的部分。

如果没有这些努力,我们将需要更大规模的数据中心。但人工智能不应该仅仅局限于那些用得起超算的人群。在那些从事最高级深度学习研究的大学里,“拥有较少算力的大学已然成为少数派。”Thompson说,“深度学习俱乐部的玩家仍然为数不少,但是随着计算负担上升,参与者的数量会越来越少。一些人已经在出局的路上了。”

成本是可以削减的,这可能是初创公司赢得客户、对抗现有企业的一种方式。AWS去年将Habana Labs的芯片添加到自己的云端,并称这家英特尔旗下的以色列设计公司将云端运营成本降低了40%。Habana Labs首席商务官Eitan Medina表示:“为了让AI惠及所有人,而不仅仅是富人,你确实需要提高性价比。”

AI本就存在着不平衡的问题,而硬件的不平等使用加剧了这一点。“这意味着我们只会看到硬币的一面。”英伟达新兴领域负责人Kate Kallot说,“如果你不考虑世界上的大部分人口……我们将如何解决世界各地的挑战?” 她提到了联合国的可持续发展目标:许多AI研究人员正在将他们的工作转向应对贫困和气候危机等挑战,而这些议题将在很大程度上影响新兴市场。

还有许多其他挑战需要面对。疫情期间处理器的制造受到限制,而去年中美之间的贸易摩擦引发了人们对全球芯片工厂主要集中在亚洲的担忧。欧盟最近承诺,到2030年将会生产全球五分之一的高端芯片。虽然英特尔有自己的工厂,但芯片设计公司大都将制造外包——英伟达的芯片是由中国台湾的台积电公司制造的。2021年3月,英特尔宣布计划在美国开设两家新工厂,首次为外部设计公司代工芯片,这或许将为美国的芯片制造带来更多控制权。

当这些障碍被克服,芯片不断发展,人工智能会将触角延伸到每一处角落,就像万物互联的浪潮,从面包机到冰箱的各种设备都加入了应用程序与Wi-Fi支持。但在未来,智能不仅意味着连入互联网,还意味着人工智能的嵌入。AI将无处不在。

撰文:Nicole Kobie

翻译:周舒义

审校:魏潇

引进来源:wired

本文来自:中国数字科技馆

特别声明:本文转载仅仅是出于科普传播信息的需要,并不意味着代表本网站观点或证实其内容的真实性;如其他媒体、网站或个人从本网站转载使用,须保留本网站注明的“来源”,并自负版权等法律责任;作者如果不希望被转载或其它相关事宜,请与我们接洽。

[责任编辑:环球科学]

京公网安备11010502039775号

京公网安备11010502039775号